Los algoritmos, esos mayordomos silenciosos

Hace más de dos décadas Nicholas Negroponte vaticinaba el Daily Me como la gran innovación informativa: un periódico diario con las noticias que nos interesaran sin que otros decidieran por nosotros qué era lo más importante del día. A ellos ayudaba la eterna justificación de la escasez de espacio en el periódico o de tiempo en la radio y televisión. Pero llegó internet a ensanchar el mundo. ¿O no tanto?

En esta sociedad postindustrial nos parece una bendición la libertad de elección, decidir con el mando a distancia si vemos una serie en HBO, un vídeo de YouTube o un álbum de Google Fotos sin tener que estar sujetos a la tiranía del primetime. Así, las charlas de café del día siguiente no van de “viste anoche cuando…” sino “estoy viendo una serie que va sobre tal…” y hasta podríamos decir que es sumamente enriquecedor porque nos aporta nuevas visiones.

Huir de ese framing de los medios tradicionales parece que solo puede traer ventajas. La mala noticia es que también supone pérdidas y estas son más difíciles de evidenciar. Por un lado, en cierta medida flaquea una esfera pública compartida como repertorio de discusión común, pero por otro no nos damos cuenta de que esos viejos “censores mediáticos” se ven reemplazados por “otros” más discretos, los cada vez más cuestionados algoritmos. Y es que probablemente la propia serie de HBO, el vídeo de YouTube o la selección de nuestras fotos en la nube, no fue tanto una elección personal como sí una recomendación predictiva bajo esa nueva sofisticada tecnología que es la inteligencia artificial aplicada al consumo.

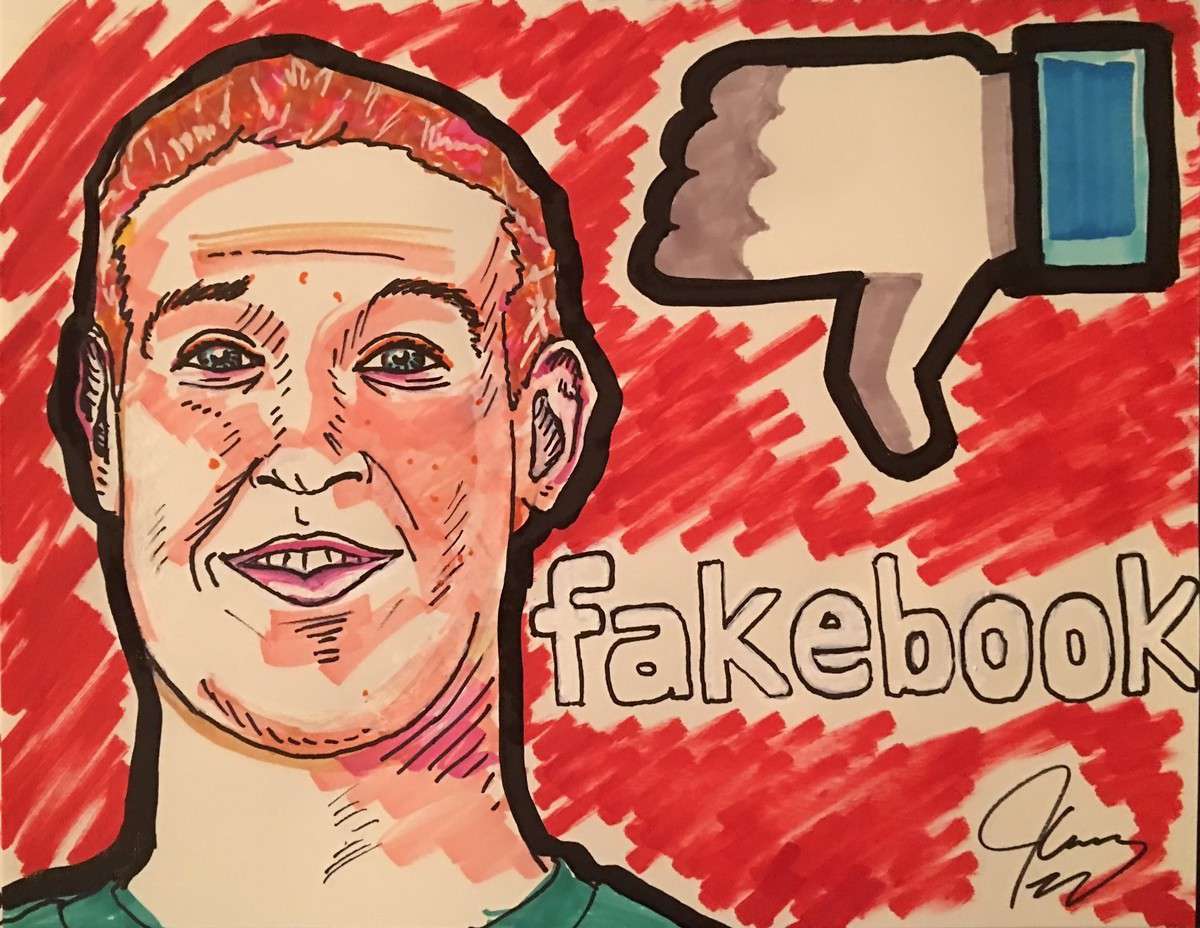

El algoritmo, ese silencioso mayordomo que nos facilita la vida, que nos dice qué nos gusta y qué no, que nos hace ser más eficientes sin perder tiempo buscando, ese algoritmo que nos limpia el muro de Facebook de aquello que considera menos relevante o que jerarquiza unos mensajes sobre otros en Instagram. Ese mayordomo desconocido que viene a facilitarnos la vida y del que nada sabemos. Ese intermediario que nos ordena el mundo, nos lo “personaliza” para liberarnos de la ardua tarea de pensar qué queremos consumir y nos pone el menú en la mesa. Ese invisible algoritmo que nos construye un mundo, un mundo a nuestra altura, pero a una altura que corre el riesgo de hacerse más pequeña, menos diversa, más pobre.

Así nos encontramos con grandes sesgos y tomas de decisiones que las máquinas hacen por nosotros como inferir que si hay una persona en una foto en un entorno doméstico será un mujer o confundir gorilas con personas negras en un buscador de imágenes. Sucede que en su aparentemente inocente “efecto espejo” vienen a reforzar nuestros peores comportamientos como humanos, pero lo importante sería que aprendiéramos a programarlos para que nos ayuden a ser mejores personas y con ello corregir nuestros defectos como sociedad (machismo, racismo, xenofobia, etc.).

¿Y qué sabemos de esos algoritmos? Prácticamente nada y lo peor es que probablemente ni quien los crea tenga todas las respuestas pues la criatura aprende a tomar sus propias decisiones, como decía Borja Adsuara hace unos días en el debate de #Nuestrosdatos, y como en cierta manera empiezan a apuntar las reservas de Google, Apple o Facebook cuando llaman la atención sobre esta deriva. Es lo que tiene el machine learning, y su base en inteligencia artificial, que aprende y aplica su propia inteligencia… artificial.

En el Seminario sobre Competencias Digitales en el que participé en septiembre en la Universidad de Coventry ya apuntábamos este fenómeno y la necesidad de empezar a introducir la alfabetización algorítmica como una competencia fundamental para entender el mundo en el que nos movemos. Quizás no seamos capaces de deconstruir el algoritmo y saber qué nos cuenta y qué nos oculta, pero al menos conviene señalar su poder y la burbuja informativa en la que vivimos en gran parte por su acción silenciosa e invisible. Ser conscientes como ciudadanos de que solo vemos una parte de la realidad, que quizás ni siquiera es tan real, es ya un poderoso avance.

En este sentido me resultó interesante cómo la propia María Sefiradi, vicepresidenta de Wikimedia Foundation destacaba hace unos días que Wikipedia no opere bajo algoritmos de recomendación, que no nos confine en burbujas y que se mantenga neutral en las búsquedas para que sean los usuarios y usuarias quienes exploren libremente lo que quieran consultar. Un comentario que parece inocente pero que hoy cobra mucho sentido. Sonaba a web libre de aditivos y me pregunto si no tendremos que empezar a destacarlos como en las etiquetas de las comidas procesadas.